DeepSeek本地部署详细指南

DeepSeek本地部署详细指南

随着人工智能技术的飞速发展,本地部署大模型的需求也日益增加。DeepSeek作为一款开源且性能强大的大语言模型,提供了灵活的本地部署方案,让用户能够在本地环境中高效运行模型,同时保护数据隐私。以下是详细的DeepSeek本地部署流程。

一、环境准备

(一)硬件需求

最低配置:CPU(支持AVX2指令集)+ 16GB内存 + 30GB存储。

推荐配置:NVIDIA GPU(RTX 3090或更高)+ 32GB内存 + 50GB存储。

(二)软件依赖

操作系统:Windows、macOS或Linux。

Docker:如果使用Open Web UI,需要安装Docker。

二、安装Ollama

Ollama是一个开源工具,用于在本地轻松运行和部署大型语言模型。以下是安装Ollama的步骤:

访问Ollama官网:前往Ollama官网,点击“Download”按钮。 下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

下载安装包:根据你的操作系统选择对应的安装包。下载完成后,直接双击安装文件并按照提示完成安装。

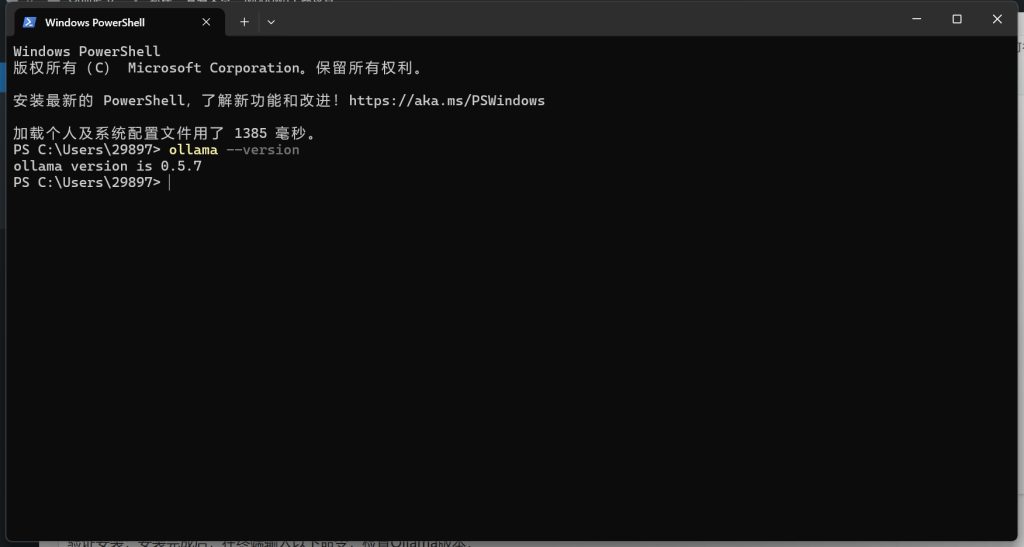

验证安装:安装完成后,在终端输入以下命令,检查Ollama版本:

ollama –version 如果输出版本号(例如ollama version is 0.5.7),则说明安装成功。

如果输出版本号(例如ollama version is 0.5.7),则说明安装成功。

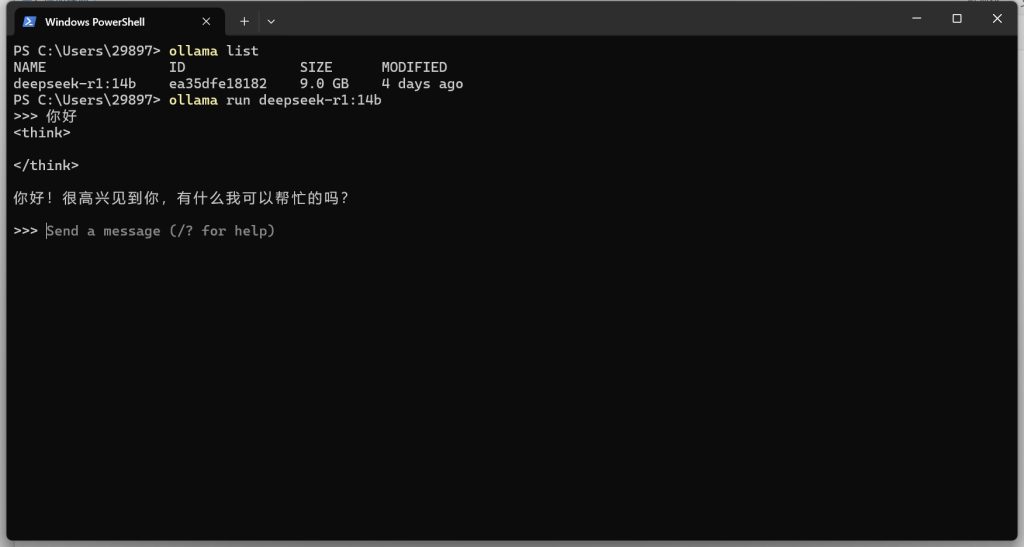

三、下载并部署DeepSeek模型

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。以下是部署步骤:

选择模型版本:

入门级:1.5B版本,适合初步测试。

中端:7B或8B版本,适合大多数消费级GPU。

高性能:14B、32B或70B版本,适合高端GPU。

下载模型:

打开终端,输入以下命令下载并运行DeepSeek模型。例如,下载7B版本的命令为:

ollama run deepseek-r1:7b

如果需要下载其他版本,可以参考以下命令:

ollama run deepseek-r1:8b # 8B版本

ollama run deepseek-r1:14b # 14B版本

ollama run deepseek-r1:32b # 32B版本

启动Ollama服务:

在终端运行以下命令启动Ollama服务:

ollama serve

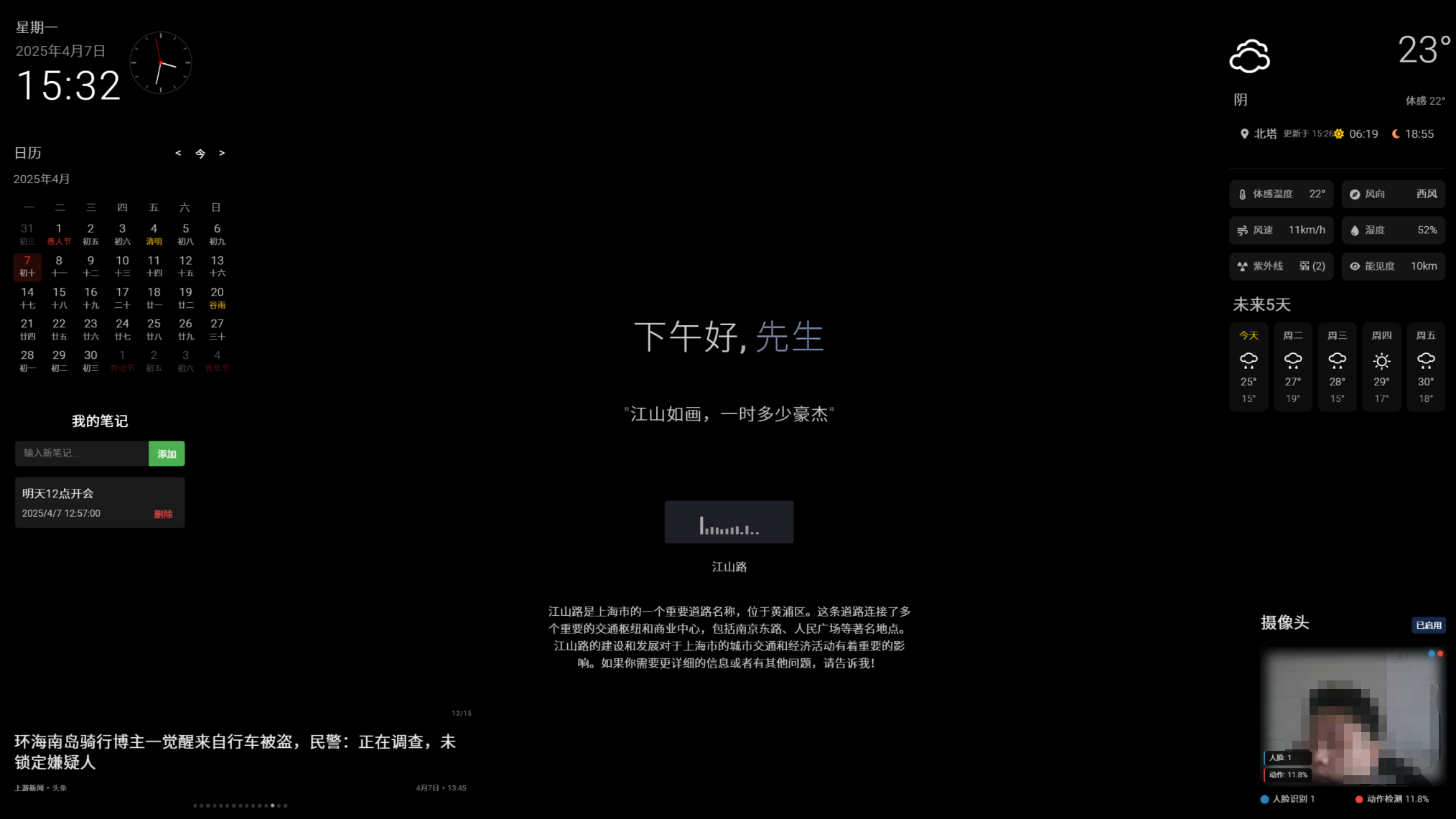

服务启动后,可以通过访问 http://localhost:11434 来与模型进行交互。

评论0